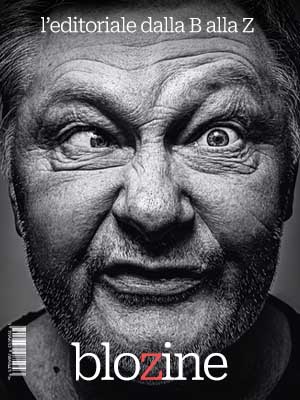

Deepfake in tempo reale, come l’intelligenza artificiale trasforma truffe e videochiamate

Il volto cambia, la voce si adatta, la truffa diventa perfetta.

Una nuova frontiera delle frodi digitali, tra volti clonati e voci fasulle che ingannano anche i sistemi di sicurezza.

Immagina di ricevere una videochiamata e trovarti davanti il volto rassicurante di un collega, un familiare o addirittura una celebrità. Peccato che, in realtà, dietro quello schermo ci sia un truffatore. È il fenomeno dei deepfake in tempo reale, una tecnica avanzata che, con pochi clic e l’aiuto dell’intelligenza artificiale, permette di modificare aspetto e voce durante una diretta, ingannando anche i sistemi di verifica più evoluti.

Dalle email fasulle ai deepfake, l’evoluzione dell’ingegneria sociale

Se fino a poco tempo fa le truffe viaggiavano tramite email sospette e messaggi truffaldini, oggi la truffa si presenta in video, con un volto familiare e una voce convincente. MARCO RAMILLI, fondatore della startup italiana IDENTIFAI, spiega come queste sofisticate tecniche di morphing siano molto più insidiose rispetto ai metodi tradizionali. Grazie alla tecnologia ’degenerativa’, la sua azienda è in grado di smascherare immagini e video creati dall’intelligenza artificiale generativa, contrastando la disinformazione e le frodi digitali.

Quando la tecnologia diventa un’arma, il caso di Mr. Deepfakes

La piattaforma americana 404 MEDIA ha acceso i riflettori sull’uso illecito dei deepfake, documentando truffe mirate soprattutto contro gli utenti più vulnerabili, come gli anziani. Emblematico il caso della chiusura di MR. DEEPFAKES, un sito dove gli utenti pagavano fino a 1.500 dollari per creare video pornografici falsi sostituendo i volti con quelli di personaggi noti. Un fenomeno inquietante che ha evidenziato quanto questa tecnologia possa essere facilmente utilizzata a scopi illeciti.

Numeri allarmanti, un’escalation senza precedenti

Dal 2017 al 2022 si sono registrati 22 incidenti legati ai deepfake. Ma la vera esplosione è arrivata nel 2023 con 42 casi, fino a toccare i 150 incidenti nel 2024, segnando un aumento del 257%. E i dati del primo trimestre 2025 sono ancora più preoccupanti: ben 179 episodi, già superiori del 19% rispetto all’intero anno precedente. Sono cifre che dimostrano quanto rapidamente stia crescendo il rischio legato a queste tecnologie.

Oltre ai video, anche le voci diventano armi di frode

Le truffe non si fermano ai volti. Le voci generate artificialmente sono sempre più utilizzate per ingannare gli utenti. Come racconta RAMILLI, bastano pochi secondi di registrazione per clonare la voce di un parente o di una persona di fiducia. Nei settori bancario e assicurativo, si moltiplicano i casi di documenti falsi e scontrini contraffatti. Ma il vero pericolo è l’uso massiccio di immagini e voci di personaggi famosi, prelevate dai social, per manipolare l’opinione pubblica o influenzare eventi politici.

Dal caso Ucraina ai video falsi di Trump, l’Italia in prima linea

Durante il conflitto in Ucraina e più di recente con episodi di disinformazione politica, la tecnologia di IDENTIFAI ha supportato la piattaforma NEWSGUARD nello smascherare video falsi di DONALD TRUMP. Uno di questi lo mostrava mentre minacciava il Pakistan in un discorso mai pronunciato, con la voce creata artificialmente e il movimento delle labbra modificato digitalmente. Secondo RAMILLI, le frodi basate sull’intelligenza artificiale rappresentano oggi il 5% del totale, ma si prevede che entro quattro anni raggiungeranno il 60-70%. La sfida sarà riuscire a mantenere la fiducia nel digitale, adottando strumenti efficaci per verificare l’autenticità di ciò che vediamo e sentiamo.

12 Maggio 2025

© team icoe, editoriale blozine

blozine editoriale no-profit della

Centro studi su innovazione, comunicazione ed etica.

Copywriters

Francesca S., Matteo R., Laura A., Antonella B., Giorgio F., Anna C., Miriam M., Stefano G., Adele P. e Francesca N.

Chi siamo

iscriviti sulla nostra pagina Facebook e non perderai nessuna notizia!